17.1.4. Trasformazione di probabilità di densità#

17.1.4.1. Variabile singola#

17.1.4.1.1. Cambio di variabile#

17.1.4.1.1.1. Traslazione#

Data la variabile casuale \(X\) con distribuzione di probabilità \(f_X(x)\) nota, la variabile casuale

ha funzione di probabilità

Tra la media e la varianza delle due variabili casuali valgono le relazioni

La dimostrazione è lasciata come esercizio.

Dimostrazione.

La probabilità che la variabile \(Y = X + a\) abbia valore \(y = x + a \in [ y_0, y_0 + dy ]\), è uguale alla probabilità che l’evento \(X\) abbia valore \(x \in [x_0, x_0 + dx]\), con \(x_0 = y_0 - a\) e \(dy = dx\),

Per la definizione di densità di probabilità,

dal confronto tra i due termini, e dall’arbitrarietà di \(x_0\) e \(dx\), si ottiene \(f_{X}(x) = f_Y(x-a)\).

17.1.4.1.1.2. Scalatura#

Data la variabile casuale \(X\) con distribuzione di probabilità \(f_X(x)\) nota, la variabile casuale

ha funzione di probabilità

Tra la media e la varianza delle due variabili casuali valgono le relazioni

La dimostrazione è lasciata come esercizio.

Dimostrazione.

La probabilità che la variabile \(Y = \frac{X}{a}\) abbia valore \(y = \frac{x}{a} \in [ y_0, y_0 + dy ]\), è uguale alla probabilità che l’evento \(X\) abbia valore \(x \in [x_0, x_0 + dx]\), con \(x_0 = a y_0\) e \(dy = a dx\),

Per la definizione di densità di probabilità,

dal confronto tra i due termini, e dall’arbitrarietà di \(x_0\) e \(dx\), si ottiene \(f_{X}(x) = \frac{1}{a} f_Y\left(\frac{x}{a}\right)\).

17.1.4.1.1.3. Trasformazione affine#

Combinando la traslazione e la scalatura, si ottiene la più generale trasformazione affine

usata spesso come scalatura delle variabili nel preprocessing. todo riferimento a scalatura di variabili su valori significativi del problema, per bilanciare il problema e lavorare con variabili non-dimensionali significatie con lo stesso ordine di grandezza (!!!)

Tra la media e la varianza delle due variabili casuali valgono le relazioni

La dimostrazione è lasciata come esercizio.

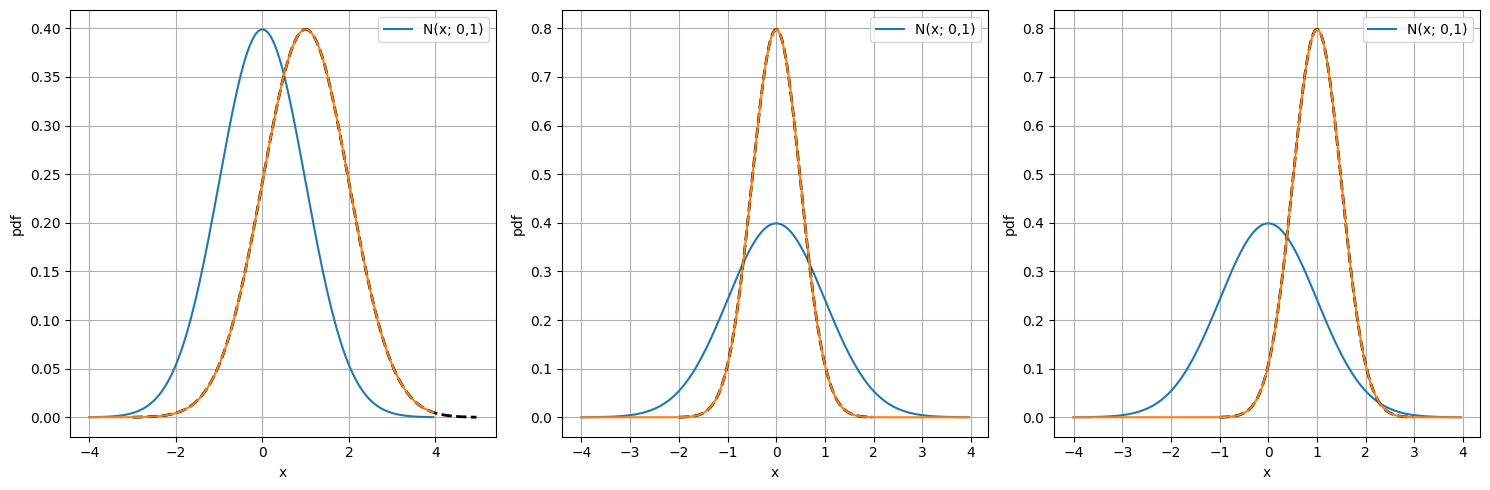

Le tre trasformazione discusse vengono applicate alla variabile normale \(X \sim N(x; \mu=0, \sigma^2=1)\). In particolare si mostrano gli effetti delle trasformazioni: 1. \(X = Y + 1\); 2. \(X = 2 Y\); 3. \(X = 2 (Y - 1)\)

Show code cell source

%reset -f

import numpy as np

import matplotlib.pyplot as plt

from scipy.stats import norm

# Define parameters for the distributions

mu, sigma = 0., 1. # Property of Gaussian

a_transl, a_scale = 1., 2.

transl_v = np.array([ a_transl, 0., a_transl ])

scale_v = np.array([ 1., a_scale, a_scale ])

mu_v = mu + transl_v

sigma_v = sigma / scale_v

# Create x values for the distributions

x0_plot = np.arange(-4.,4., .05)

p0_norm = norm.pdf(x0_plot, loc=mu, scale=sigma)

xv_plot, pv_norm = [], []

for i in range(len(transl_v)):

xv_plot += [ x0_plot / scale_v[i] + transl_v[i] ]

pv_norm += [ norm.pdf(x0_plot, loc=mu_v[i], scale=sigma_v[i]) ]

# Create subplots

fig, axes = plt.subplots(1, 3, figsize=(15, 5))

# Plot

for i in range(len(transl_v)):

axes[i].plot(x0_plot, p0_norm, label="N(x; 0,1)") #

axes[i].plot(xv_plot[i], p0_norm*scale_v[i], '--', color='black', lw=2)

axes[i].plot(x0_plot, pv_norm[i])

axes[i].set_xlabel("x")

axes[i].set_ylabel("pdf")

axes[i].grid()

axes[i].legend()

# Adjust layout

plt.tight_layout()

plt.show()

17.1.4.2. Multi-variabile#

17.1.4.2.1. Cambio di variabili#

17.1.4.2.2. Combinazione di variabili#

17.1.4.2.2.1. Somma#

Date due variabili casuali \(X\), \(Y\), con probabilità congiunta \(p_{XY}(x,y)\), la loro somma \(Z = X + Y\) è una variabile casuale dipendente con distribuzione di probabilità

Se le due variabili sono tra di loro statisticamente indipendenti, la densità di probabilità congiunta è uguale al prodotto delle densità di probabilità delle singole variabili, \(p_{XY}(x,y) = p_X(x) p_Y(y)\), e quindi la densità di probabilità della somma è uguale alla convoluzione tra le densità di probabilità delle due variabili,

Valore atteso

Il valore atteso della somma è quindi

e, nel caso in cui le due variabili siano tra di loro statisticamente indipendenti,

Varianza

La varianza della somma è

e nel caso le due variabili siano tra di loro statisticamente indipendenti,

17.1.4.2.2.2. Prodotto#

Date due variabili casuali \(X\), \(Y\) con probabilità congiunta \(p_{XY}(x,y)\), il loro prodotto \(Z = X \cdot Y\) è una variabile casuale dipendente con distribuzione di probabilità

Se le due variabili sono statisticamente indipendenti

(todo ha qualche uso questa formula? Si ritrova la convoluzione con il cambio di variabili \(z=e^v\), \(x=e^u\))

Valore atteso

Il valore atteso del prodotto è

e, nel caso in cui le due variabili siano tra di loro statisticamente indipendenti,

Varianza

La varianza del prodotto è

e nel caso le due variabili siano tra di loro statisticamente indipendenti,

In termini di correlazione, \(R_X^2 = \sigma_X^2 + E[X]^2\),